為什麼要搞懂這個?

假設你想做一個 AI 應用(聊天機器人、內容生成器、客服系統等等)。

現在市場上有三大 AI 服務商:OpenAI、Google Gemini、Anthropic Claude。

這三家的計費方式看起來很複雜,但實際上搞懂了很簡單。差別有多大?

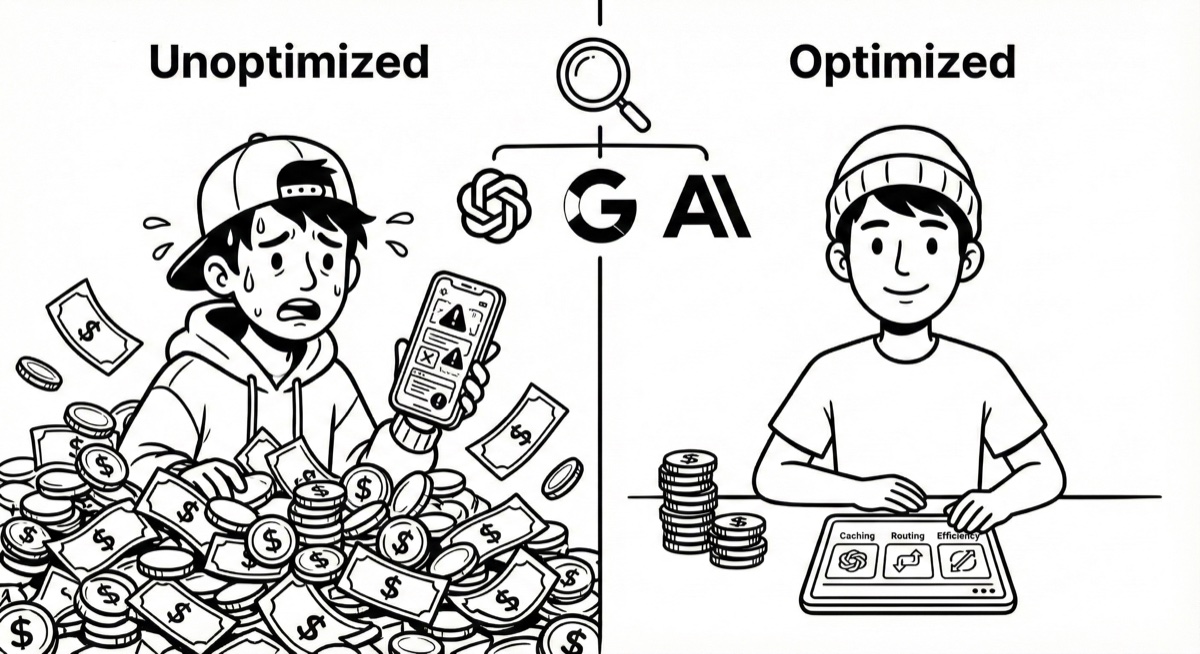

同樣處理 10 萬次對話(一般中小型應用一個月的量):

- 選對方案:$62 美金(約 2000 台幣)

- 選錯方案:$175 美金(約 5600 台幣)

- 懂優化技巧:$20-30 美金(約 600-960 台幣)

差距接近 9 倍。

這篇文章會用最簡單的方式,讓你搞懂這些計價邏輯。

基礎概念:什麼是 Token?

Token 就是「計量單位」

把 Token 想成「文字的計量單位」就好。

- 英文:1 個 token ≈ 0.75 個單字

- 中文:1 個 token ≈ 1 個字

舉例:

- 「今天天氣很好」= 6 個字 = 約 6 tokens

- “Hello world” = 2 個單字 = 約 3 tokens

AI 公司按「每百萬 tokens」收費

就像:

- 買水果:「一斤 50 元」

- 用 AI:「100 萬個 tokens 多少錢」

100 萬個 tokens 聽起來很多,但實際上大概是:

- 200 本繪本的內容量

- 或是 10 萬次短對話

三種收費項目

每次呼叫 AI,會產生三種費用:

- Input(輸入) - 你送進去的文字

- Output(輸出) - AI 回覆給你的文字

- Cached Input(快取輸入) - 重複使用的內容,價格便宜 10 倍

用麥當勞來比喻:

- Input = 你點的餐

- Output = 店員給你的餐點

- Cached Input = 辦會員卡,某些品項打折

重點是:Input 和 Output 分開算錢,而且 Cached Input 便宜非常多。

核心機制:Prompt Caching(快取)

這是最重要的省錢技巧,但多數人不知道怎麼用。

Prompt Caching 為什麼便宜 10 倍?

如果你的 AI 應用每次都要用到同樣的「系統指令」:

「你是客服助手,可以幫忙查詢訂單、處理退貨、回答產品問題。請保持專業和友善。」

這段有 30 個字。

第一次呼叫:

- AI 要「讀取」、「理解」、「處理」這 30 個字

- 付完整價格

之後每次呼叫:

- AI 發現「這段我處理過了,直接拿來用」

- 不用重新讀取和理解

- 只付 1/10 的價格

為什麼便宜?因為 AI 不用重新做一次同樣的工作。

就這麼簡單。

不用 Caching = 每次都重新處理同樣內容 用 Caching = 處理過的內容直接取用

如果你有固定內容(系統指令、知識庫、文件),不用 Caching 這部分會貴 10 倍。

三家的 Caching 機制比較

OpenAI

- 第一次:正常價格

- 之後:自動打折到 1/10

- 很直覺,自動幫你處理

Gemini

- 第一次:正常價格 + 少量儲存費(每小時幾毛錢)

- 之後:1/10 價格

- 支援文字、圖片、影片

Claude

- 第一次:稍貴一點(1.25 倍)

- 之後:0.1 倍(便宜 10 倍)

- 折扣最大,如果你重複使用率高的話

重點:如果你的應用有固定內容(系統指令、知識庫、說明文件),用 Caching 這部分會便宜 10 倍。

價格總覽:三家怎麼比較?

用「餐廳」來比喻會比較好理解:

OpenAI:從便當到米其林都有

| 模型 | Input | Output | 定位 |

|---|---|---|---|

| gpt-5-nano | $0.05 | $0.40 | 便當店(便宜、快速、堪用) |

| gpt-5-mini | $0.25 | $2.00 | 定食店(平衡品質和價格) |

| gpt-5.1 | $1.25 | $10.00 | 高級餐廳(品質好但貴) |

| GPT-5 Pro / o 系列 | $15+ | $120+ | 米其林(頂級但天價) |

Google Gemini:主打性價比

| 模型 | Input | Output | 定位 |

|---|---|---|---|

| Flash-Lite | $0.10 | $0.40 | 路邊攤(超便宜) |

| Flash | $0.30 | $2.50 | 小吃店(便宜又好) |

| Pro | $1.25 | $10.00 | 高級餐廳(對標 OpenAI) |

Claude:表面貴,但 Caching 折扣大

| 模型 | Input | Output | 定位 |

|---|---|---|---|

| Haiku 3 | $0.25 | $1.25 | 速食店 |

| Haiku 4.5 | $1.00 | $5.00 | 一般餐廳 |

| Sonnet 4.5 | $3.00 | $15.00 | 高級餐廳 |

重點:Claude 看起來最貴,但用 Caching 可以打折到 1/10。如果你的應用重複率高、內容長,Claude 可能反而最划算。

實際計算:做一個客服機器人要花多少錢?

用真實場景來算:

情境設定

- 一個月 10 萬次對話

- 每次對話:

- 你送給 AI 的內容:500 tokens(包含系統指令 + 使用者問題)

- AI 回覆:250 tokens

算總量

- 總 input:10 萬 × 500 = 5000 萬 tokens = 50M

- 總 output:10 萬 × 250 = 2500 萬 tokens = 25M

三家各要多少錢?(不用 Caching)

OpenAI gpt-5-mini

- Input:50M ÷ 1M × $0.25 = $12.5

- Output:25M ÷ 1M × $2.00 = $50

- 總計:$62.5 / 月(約 2000 台幣)

Gemini Flash

- Input:50M ÷ 1M × $0.30 = $15

- Output:25M ÷ 1M × $2.50 = $62.5

- 總計:$77.5 / 月(約 2480 台幣)

Claude Haiku 4.5

- Input:50M ÷ 1M × $1 = $50

- Output:25M ÷ 1M × $5 = $125

- 總計:$175 / 月(約 5600 台幣)

初步結論

不做任何優化的情況下:

- OpenAI 最便宜($62.5)

- Gemini 中等($77.5)

- Claude 最貴($175)

差距 2.8 倍。

但這只是「裸價」,還沒用任何省錢技巧。

用 Caching 可以省多少?

現在來優化剛剛的場景。

假設你的系統指令佔 80%

每次 500 tokens 的 input 裡:

- 400 tokens 是固定的系統指令

- 100 tokens 是使用者問題(每次不同)

用 Caching 後的成本(以 OpenAI 為例)

Input 成本

之前(不用 Caching):

- 全部 input:50M × $0.25 = $12.5

之後(用 Caching):

- 固定部分(第一次):付一次錢

- 固定部分(之後):40M × $0.025 = $1(便宜 10 倍)

- 動態部分:10M × $0.25 = $2.5

- Input 小計:$3.5

省了 $9,降了 72%。

再加上「簡單問題用便宜模型」

80% 的簡單問題(「營業時間」、「退貨流程」)用 gpt-5-nano:

- 簡單問題 output (80%):20M × $0.4 = $8

- 複雜問題 output (20%):5M × $2.0 = $10

- Output 總成本:$18(原本是 $50)

最後總成本:Input $3.5 + Output $18 = 約 $21.5 / 月

從 $62.5 降到 $21.5,省了 66%。

隱藏陷阱:額外工具費用

Web Search / Grounding

有些 AI 提供「上網查資料」功能,但另外收費。

OpenAI Web Search

- 每 1000 次查詢:$10

- 而且每次查詢算 8000 tokens

陷阱在哪?

你只是問「今天天氣」(4 個字),但 AI 如果去網路查,會被算成:

- 4 個字的問題

- 8000 個字的查詢

成本瞬間暴增 2000 倍。

Gemini Grounding

- 免費額度後:每 1000 次 $35

建議

只在真的需要時才啟用:

- 使用者明確要求最新資訊

- 內部知識庫找不到答案

- 關鍵字很新(例如昨天的新聞)

否則,就像每次去麥當勞都加購套餐,錢會燒很快。

省錢架構:三個策略

策略一:模型分層

不要所有問題都用同一個模型。

比喻:不是每餐都要吃米其林。

- 簡單問題(「營業時間」、「退貨流程」)→ 用 nano / Flash-Lite

- 一般問題(「訂單查詢」、「產品推薦」)→ 用 mini / Flash

- 複雜問題(「深度分析」、「技術諮詢」)→ 用 5.1 / Pro

80% 的問題用便宜模型,只有 20% 用貴的 = 省很多。

策略二:必做三件事

1. 記錄用量(Logging)

每次呼叫 API 都記錄:

- 用了多少 input / output tokens

- 用了哪個模型

- 有沒有用額外工具

建立簡單的 dashboard 追蹤:

- 每日成本

- 各模型使用比例

- 異常用量警報

就像記帳,你才知道錢花去哪。

2. 啟用 Caching

把固定內容(系統指令、知識庫、FAQ)放進 cache:

- 第一次付完整價

- 之後這部分便宜 90%(只付 1/10)

固定內容佔比越高,省越多。

3. 了解並選擇合適的服務層級

三家 AI 服務商都提供不同的服務層級,價格和功能差異很大。

服務層級完全解析

OpenAI 的四個層級

Standard(標準)

- 價格:正常定價(如上面表格)

- 速度:正常回應速度

- 適合:一般生產環境、即時應用

Batch(批次)

- 價格:Standard 的 50% 折扣

- 處理時間:24 小時內完成

- 限制:非即時,需要等待

- 適合:

- 大量文件分析

- 離線資料處理

- ETL pipeline

- 非即時評估任務

實例:

- Standard:gpt-5-mini input $0.25/M

- Batch:gpt-5-mini input $0.125/M(省 50%)

Realtime(即時)

- 價格:比 Standard 貴

- 功能:語音對話、即時串流

- 適合:語音助手、即時對話應用

Claude 的三個層級

Standard(標準)

- 價格:正常定價

- 速度:正常回應

- 適合:一般生產環境

Batch(批次)

- 價格:Standard 的 50% 折扣

- 處理時間:24 小時內

- 限制:非即時

- 適合:批次處理、離線分析

實例:

- Standard:Sonnet 4.5 input $3.00/M

- Batch:Sonnet 4.5 input $1.50/M(省 50%)

Priority(優先)

- 價格:比 Standard 貴約 20-30%

- 保證:更高的 rate limit、優先處理

- 適合:高流量應用、需要保證可用性

Gemini 的三個層級

Free(免費)

- 價格:完全免費

- 限制:較低的 rate limit、用於改進產品

- 適合:開發測試、小型專案

Paid(付費標準)

- 價格:正常定價

- 保證:更高 rate limit、資料不用於訓練

- 適合:生產環境、商業應用

Batch(批次非同步)

- 價格:比 Paid 便宜 50%

- 處理時間:非即時、異步處理

- 適合:非緊急任務、批次處理

實例:

- Paid:2.5 Pro input $1.25/M

- Batch:2.5 Pro input $0.625/M(省 50%)

服務層級選擇指南

什麼時候用 Standard?

✅ 預設選擇 - 適合 95% 的應用場景

- 即時回應需求

- 生產環境

- 使用者面向的應用

- 對延遲敏感

什麼時候用 Batch?

✅ 可以省 50% - 但要能接受延遲

- 每日定時報告生成

- 大量歷史資料分析

- 內容審核(非即時)

- 資料標註

- 模型評估

- 知識庫建立

重要:24 小時內完成,不適合急件

什麼時候用 Free(Gemini)?

✅ 完全免費 - 但有限制

- 開發測試環境

- 學習和實驗

- 小型個人專案

- MVP 驗證

什麼時候用 Priority(Claude)?

✅ 付費換保證 - 高流量應用

- 每秒大量請求

- 關鍵業務應用

- 需要保證 SLA

- 高峰時段不能被限流

實際成本比較

同樣處理 100 萬個 tokens:

| 模型 | Standard | Batch | 差額 |

|---|---|---|---|

| OpenAI gpt-5-mini | $0.25 | $0.125 | 省 $0.125 |

| Claude Sonnet 4.5 | $3.00 | $1.50 | 省 $1.50 |

| Gemini Flash | $0.30 | N/A | - |

如果每月處理 1 億 tokens:

- Standard:$25 (OpenAI) / $300 (Claude)

- Batch:$12.5 (OpenAI) / $150 (Claude)

- 每月可省 $12.5 - $150

策略三:減少浪費

縮短系統指令

浪費版:

「親愛的用戶您好,非常感謝您使用我們的服務。我是您專屬的 AI 客服助理,很榮幸能為您服務。我可以協助您處理各種問題,包括但不限於訂單查詢、退換貨申請、產品諮詢等等。請問您今天需要什麼協助呢?」

69 個字

精簡版:

「您好,我是客服助手,可以幫您查訂單、退貨、或回答產品問題。請問需要什麼協助?」

25 個字

省了 64%。

不要累積對話歷史

浪費做法:

第 1 輪對話:「營業時間?」 第 2 輪對話:把第 1 輪也一起送給 AI 第 3 輪對話:把第 1、2 輪都送給 AI … 第 10 輪對話:把前 9 輪都送給 AI

越來越貴。

省錢做法:

每 3-5 輪就做一次「摘要」:

「用戶詢問營業時間和產品價格,我已回答。」

只給 AI 這個摘要,不給完整記錄。

省很多 tokens。

決策指南:四種情境

情境 1:預算有限,追求極致便宜

適合:

- 個人專案、學生作業

- 簡單功能(分類、簡答)

- 高頻次呼叫

建議:

- OpenAI gpt-5-nano 或 Gemini Flash-Lite

- 就像選便當店,便宜堪用

情境 2:日常應用,平衡品質和成本

適合:

- 客服機器人、內容生成

- 中小型企業應用

- 需要一定品質

建議:

- OpenAI gpt-5-mini 或 Gemini Flash

- 就像選定食店,品質好又不貴

- 兩家差不多($62 vs $77),看你習慣哪個

情境 3:追求最高品質

適合:

- 研究、分析、重要決策

- 複雜推理任務

- 預算充足

建議:

- OpenAI gpt-5.1 / o3 或 Gemini Pro 或 Claude Sonnet

- 就像選高級餐廳

- 三家都試試,看哪個回答品質最好

情境 4:重複率高、內容長

適合:

- 法務文件分析

- 長篇審查

- 固定知識庫問答

建議:

- Claude Haiku / Sonnet + Caching

- 雖然表面最貴,但 Caching 折扣最大

- 實際可能最便宜

比喻:

Claude 就像月票最貴但折扣最大的公車系統:

- 單程票:最貴

- 月票折扣:最多

- 每天搭:反而最划算

總結:記住三個重點

1. 選對模型

- 日常應用:gpt-5-mini / Flash

- 極致便宜:nano / Flash-Lite

- 最高品質:5.1 / Pro

2. 一定要用 Caching

如果有固定內容(系統指令、知識庫),被 cache 的部分便宜 10 倍。固定內容佔比越高,省越多。

3. 開始追蹤和優化

- 記錄每次用量

- 建立成本監控

- 定期檢視和調整

真實案例對比

同樣功能(10 萬次對話 / 月):

| 做法 | 成本 | 說明 |

|---|---|---|

| 不懂,亂選 | $175 | 選了 Claude 但不會用 |

| 懂基本的 | $62.5 | 選了 OpenAI mini |

| 完全搞懂 | $20-30 | Caching + 分層 + 優化 |

懂的人花 $20,不懂的人花 $175

差了 9 倍。

結語

選擇 AI 服務就像選餐廳:

- 不是每餐都吃米其林(太貴)

- 不是每餐都吃泡麵(品質差)

- 看情況選適合的

記住三件事:

- 簡單問題用便宜模型,複雜問題才用貴的

- 固定內容一定要用 Caching

- 記錄和監控,知道錢花去哪

這樣你就能用最少的成本,做出高品質的 AI 應用。